从o1-mini到DeepSeek-R1,万字长文带你读懂推理模型的历史与技术

从o1-mini到DeepSeek-R1,万字长文带你读懂推理模型的历史与技术自 OpenAI 发布 o1-mini 模型以来,推理模型就一直是 AI 社区的热门话题,而春节前面世的开放式推理模型 DeepSeek-R1 更是让推理模型的热度达到了前所未有的高峰。

自 OpenAI 发布 o1-mini 模型以来,推理模型就一直是 AI 社区的热门话题,而春节前面世的开放式推理模型 DeepSeek-R1 更是让推理模型的热度达到了前所未有的高峰。

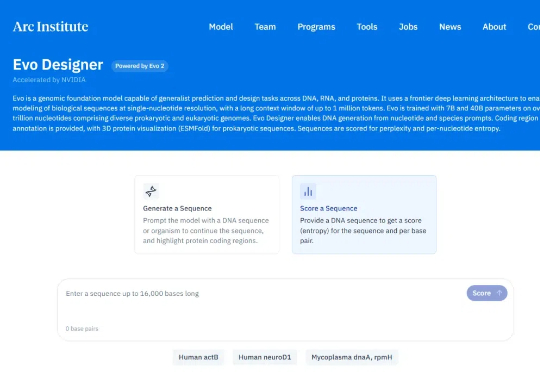

生物学大模型又迎新里程碑!2025 年 2 月 19 日,来自 Arc Institute、英伟达、斯坦福大学、加州大学伯克利分校和加州大学旧金山分校的科学家们,联合发布了生物学大模型 Evo2。

众所周知,目前 DeepSeek R1 有一个很大的痛点是不支持 Function Call 的。GitHub 上有许多开发者都表达了这一诉求。

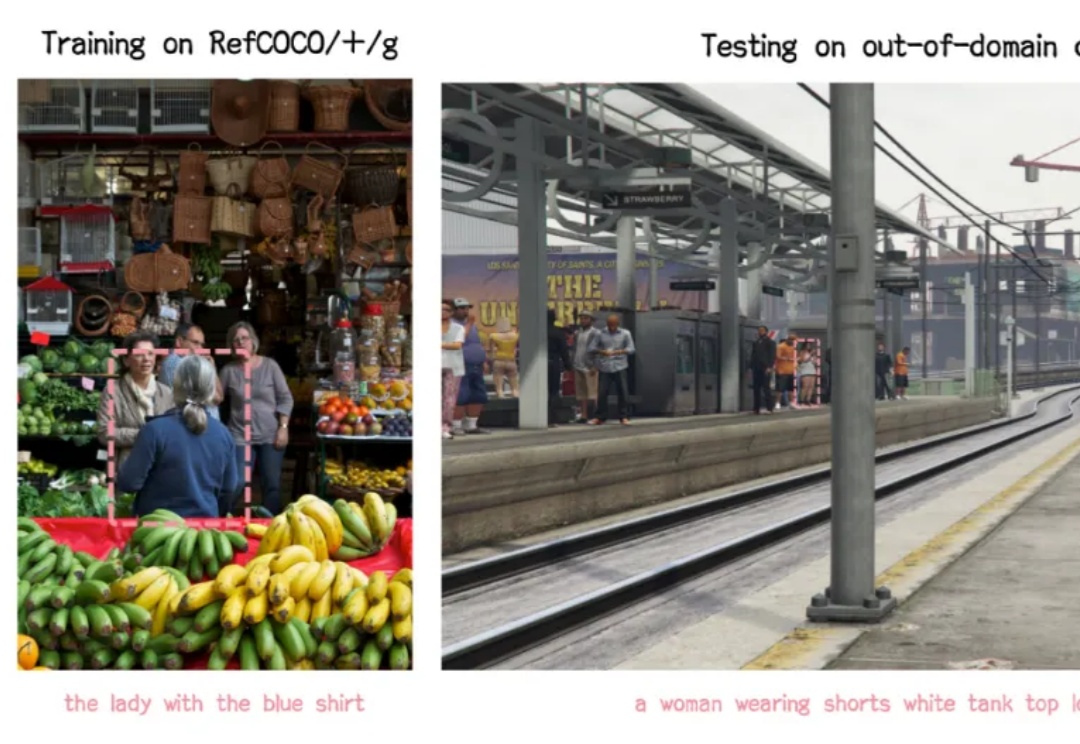

嘿,各位开发小伙伴,今天要给大家安利一个全新的开源项目 ——VLM-R1!它将 DeepSeek 的 R1 方法从纯文本领域成功迁移到了视觉语言领域,这意味着打开了对于多模态领域的想象空间!

Sam Altman 又当了一回谜语人。2 月 16 日,他宣布更新了我们的老朋友 GPT-4o,却没说细节。

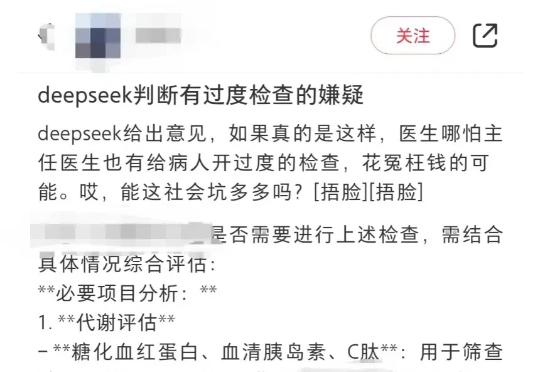

「医生,你开的这些检查都没有必要,属于『过度检查』。」「谁说没有必要?」「DeepSeek 说的。」最近,有位家属在社交平台上发文表示,孩子在医院接受的部分检查被 DeepSeek 判断为「可能非必要」,于是这位家属认为接诊的医生是在「开过度的检查」,让人「花冤枉钱」。

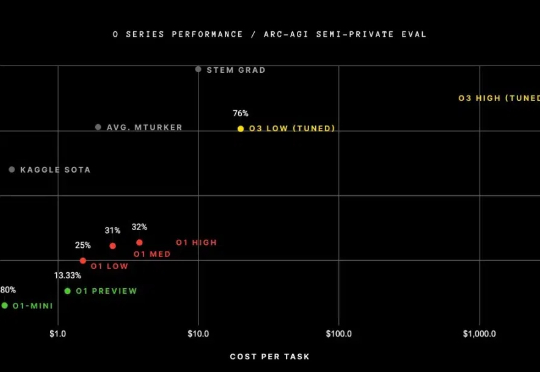

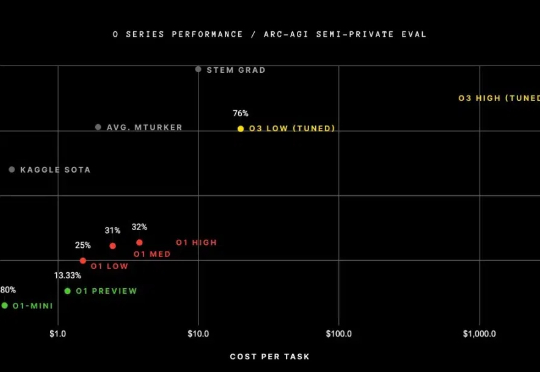

这个AI领域千亿级市场,将辐射千家万户。 DeepSeek-R1横空出世,打响了大模型比拼性价比的第一枪。 Meta、OpenAI等国外头部大模型厂商纷纷复刻或变相降价。比DeepSeek-R1晚两周发布的OpenAI o3-mini模型,定价比前代模型o1-mini降低了超6成,比前代完整版的o1模型便宜超9成。

“我十分想见梁文锋。” DeepSeek火了之后,投资圈开始焦虑了。 根据“路边消息社”报道,“最近想要见DeepSeek创始人梁文锋,需要汇报到地方办公室。”根据报道,最近想要约见梁文锋的投资机构太多,为了保护这位AI大牛,想约见他的机构,需要先报到省委办公厅。

大模型混战,一边卷能力,一边卷“低价”。 DeepSeek彻底让全球都坐不住了。 昨天,马斯克携“地球上最聪明的AI”——Gork 3在直播中亮相,自称其“推理能力超越目前所有已知模型”,在推理-测试时间得分上,也好于DeepSeek R1、OpenAI o1。不久前,国民级应用微信宣布接入DeepSeek R1,正在灰度测试中,这一王炸组合被外界认为AI搜索领域要变天。

当 DeepSeek 在春节期间爆火,所有人都在猜测国内 AI 厂商将会如何跟进时,腾讯元宝上周宣布接入满血版 DeepSeek R1,APPSO 体验后彻底告别了「服务器繁忙」。而就在刚刚,腾讯元宝正式推出自研的 Hunyuan T1 快速深度思考模型,给了我们两种深度思考模型的选择,APPSO 也提前体验了这款模型,第一时间给大家送上使用指南。